|

如果历史上的极权政府未被打败,如今它们会是什么样子?纳粹使用的是20世纪的技术,直到二战战败才终止发展。如果纳粹比美国更早制造出原子弹,他们会有多强大,能撑多久?纳粹如果掌握当时最先进的技术,可以巩固权力,改变历史进程。

当我们试想存在的风险时,像核战争或小行星撞击这样的惨剧经常浮现在我们的脑海中。然而,未来还有一个威胁不太为人所知——虽然它不太可能会让人类灭绝,但同样糟糕。

它就像“被锁链锁住的世界”,在这个场景中,就像曾经的思维实验一样,一个全球极权政府用新技术把世界上大多数人锁在永久的痛苦之中。如果这听起来很可怕,对,就是这样。但这有可能吗?研究人员和哲学家们开始思考它是如何产生的——更重要的是,我们能做些什么来避免这种情况出现。

有可能的风险都是灾难性的,因为它们把人类困在单一命运中,比如文明永久崩溃或人类灭绝。这些灾难可能是由自然原因造成的,如小行星撞击或超级火山爆发,也可能是核战争或气候变化等因素造成的。剑桥大学存在风险研究中心(Centrefor the Study of Existential Risk)的学术项目经理海顿·贝尔菲尔德(HaydnBelfield)表示,如果这种情况发生,将是“人类命运的悲惨结局”,并将让我们愧对几百代祖先。

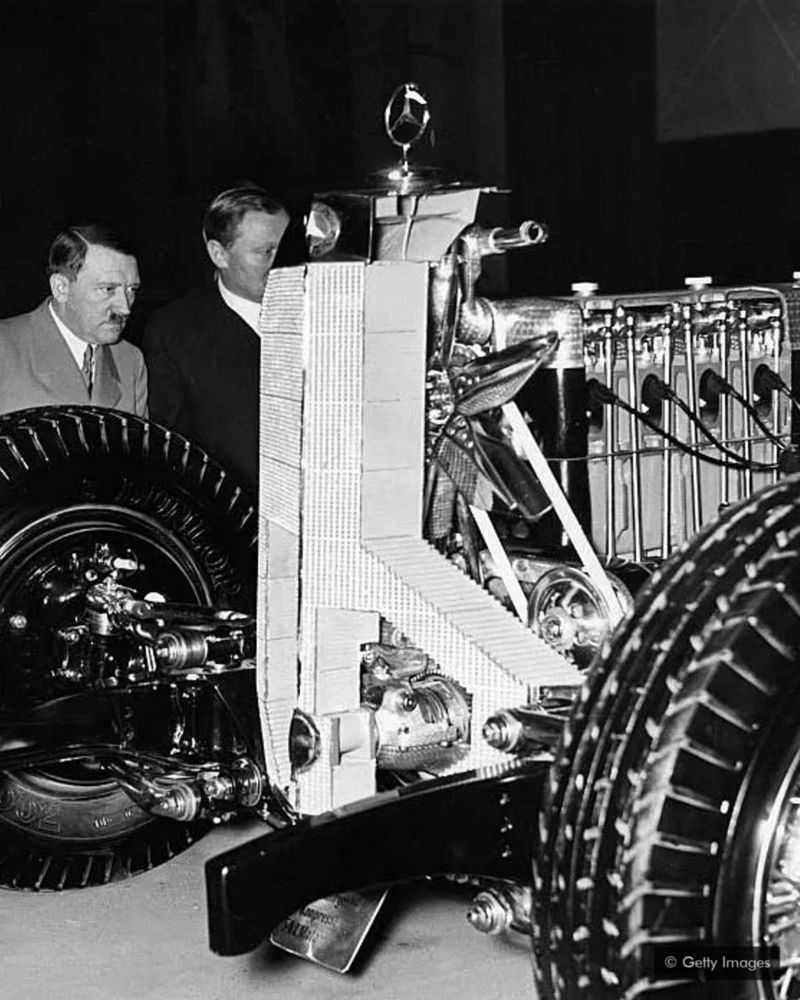

希特勒检查了当时德国的先进工程——如果纳粹拥有了不可战胜的优势呢?

牛津大学人类未来研究所(Future of Humanity Institute)高级研究员托比·奥德(TobyOrd)认为,本世纪发生自然灾害的几率不到两千分之一,因为没有自然灾害,人类已经存活了2000个世纪。然而,如果计算人为灾难,奥德相信这种可能性会增加到惊人的六分之一。他把这个世纪称为“悬崖”,意思是人类失去未来的风险从未如此之高。

伦敦一家非营利性研究机构——长期风险中心(Center on Long-TermRisk)的研究人员对未知风险进行了进一步研究,提出了更令人不寒而栗的预测。这些“超级风险”被定义为“天文级的痛苦,远远超过迄今为止地球上存在的所有痛苦”。“在这种情况下,数十亿人仍存活,但质量极端低劣,前景黯淡,死亡将是更好的选择。”简而言之:一个负价值的未来比一个没有价值的未来更糟糕。

这就是“被锁链锁住的世界”场景的由来。如果一个邪恶的组织或政府突然通过技术获得了统治世界的权力,并且没有什么可以阻挡它,它可能会导致很长一段时间的人间苦难。2017年,全球优先项目(GlobalPrioritiesProject)与人类未来研究所和芬兰外交部联合发布了一份关于潜在风险的报告,警告称,“在漫长未来,人类如果由一个特别残忍的全球极权国家统治,可能比彻底灭绝更糟糕”。

单例模式的假设

尽管全球极权主义仍是一个小众研究主题,但潜在风险领域的研究人员正越来越多地将注意力转向最有可能导致全球极权主义的原因:人工智能。

牛津大学人类未来研究所主任尼克·博斯特罗姆(Nick Bostrom)在他的《单例假说》(singletonhypothesis)中,解释了如何利用人工智能或其他强大技术形成一个全球政府,以及它可能无法被推翻的原因。他写道,如果该机构“利用人工智能或分子纳米技术的突破取得决定性领先地位”,那么就可能出现“最高级别单一决策机构”所掌控的世界。一旦掌权,它将全面利用防止内部挑战的技术进步,如监视或自主使用武器,并在这种技术垄断下保持永久稳定。

如果单一决策是极权主义的,人类文明将是暗淡的。曾经,即使是在制度最严格的国家,新闻也可以从其他国家流入,人们也可以选择流亡。全球性的极权主义统治会彻底消灭这些希望。比灭绝更糟糕的是,“这将意味着我们完全没有自由,没有隐私,没有逃脱的希望,完全没有能力来控制我们的生活,”塔克·戴维(TuckerDavey)说,他是马萨诸塞州未来生命研究所(Life Institute inMassachusetts)的一名作家,该研究所专注于潜在风险的研究。

“在过去的极权主义政权中,有太多的偏执和心理折磨,因为你不知道自己是否会因为说错话而被杀,”他继续说。“现在想象一下,甚至没有这种问题,你说的每一句话都会被举报和分析。”

奥德在最近的一次采访中说:“我们可能目前还没有技术实现这一点,但正在开发的技术让这种状况越来越有可能。”“在未来100年的某个时候,这似乎有可能成为现实。” 人工智能和威权主义

尽管极权政府统治全球仍不太可能,但人工智能已经在一些国家促成了威权主义,在另一些国家,机会主义暴君攫取了越来越多的基本公共权力。

“我们看到,人工智能带给人类的未来,已经从非常的乌托邦转变为反乌托邦,这发人深省。”新美国安全中心的兼职高级研究员埃尔莎·堪尼亚(ElsaKania)说,这是一个无党派非营利研究国家安全和国防政策的中心。

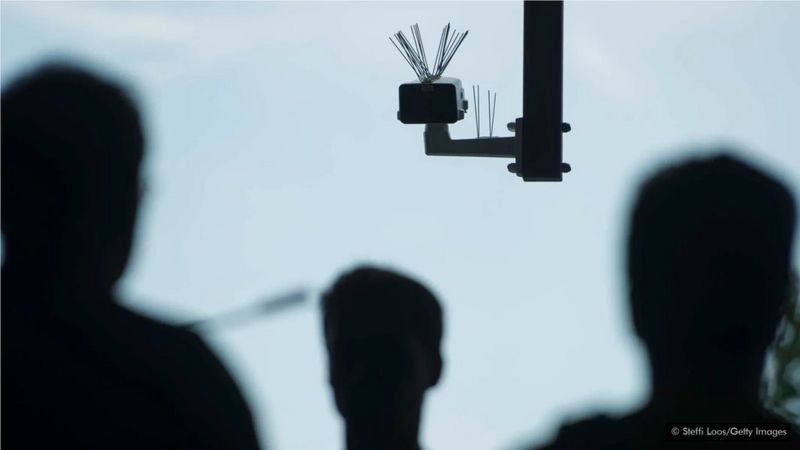

如果一个仁慈的政府在任何地方都安装监控摄像头,会让极权主义者在未来更容易统治国家。 在过去,监视需要数十万人参与,例如东德每100个公民中就有一个人是线人。但现在,这可以通过技术实现。在2019年停止国内监控之前,美国国家安全局(NationalSecurityAgency)收集了数亿美国人的通话和短信记录。据估计,英国各地有400万到600万个闭路电视摄像头。全球最受监控的20个城市中,有18个在中国,但伦敦位居第三。它们之间使用的技术没有差别,而差别更多的在于使用技术的方式。

如果美国和英国将非法行为的定义扩大到批评政府或信仰某些宗教会怎样?利用信息技术监控的基础设施已经没有问题,而美国国家安全局已经开始使用人工智能进行试验,各机构搜集数据能够比以往更快。

除了加强监控,人工智能还能制造网络虚假信息,这是威权政府可用的另一个工具。由人工智能制造的高级谣言工具,可以传播虚假的政治信息,并通过算法在社交媒体上进行微观定位,让宣传显得更有说服力。这破坏了民主制度的根基,即公民的认知安全。人们无法确定什么是事实,也无法据此采取行动。

贝尔菲尔德说:“在过去的几年里,我们看到了过滤信息导致的社会思潮和行动,人们被各种各样的算法所误导,开始相信各种各样的阴谋论,即使这些不是完全意义上的阴谋论,也只是部分真相。”“你可以想象,事情会变得越来越糟,尤其是深度造假之类的事情,直到我们越来越难以作为社会群体,决定哪些是事实,是我们必须做的,然后采取集体行动。” 先发制人的措施

由贝尔菲尔德和来自14个机构的25位作者撰写的《恶意使用人工智能》(The Malicious Use of ArtificialIntelligence)报告预测,这样的趋势将使政治安全受到更加严重的威胁,并在未来几年新的威胁不断出现。尽管如此,贝尔菲尔德说他的工作让他充满希望,而积极的方面,比如关于人工智能的民主的讨论和政策制定(例如,欧盟考虑在公共场所暂停面部识别),让我们对避免灾难性的命运仍然可以保持乐观。

戴维也同意这个说法。“我们现在需要决定:使用人工智能,怎样是可接受?怎样是不可接受的?”“我们需要小心,不要让它控制我们的这么多基础设施。如果我们给警察配备了面部识别系统,而联邦政府因此可以收集我们的所有数据,那是个糟糕的开始。”

如果你对人工智能是否有如此强大的力量仍持怀疑态度,不妨想想核武器即将被发明前的世界。在第一次核链式反应的三年前,即使是试图实现这一目标的科学家也认为这是不可能的。人类也没有为核能突破做好准备,在各种条约和协定出台,限制这种致命武器在全球扩散之前,幸好没有发生巨大的灾难,而那时,人类是徘徊在"相互毁灭"的边缘。我们应将历史教训与远景结合起来,为发明某种强大的技术做好准备。我们可以在人工智能方面做同样的事情。

世界或许无法阻止像纳粹那样的极权主义政权在未来再次崛起,但我们至少可以避免让他们拥有无限的权力。

此页来自:加拿大新闻网 https://cacnews.ca

免责声明:本网转载的文章仅为传播更多信息之目的,本网未独立核实其内容真实性,文章也不代表本网立场。如文章侵犯了你的权利,请联系我们修改或删除。本网提供的内容,包括并不限于财经、房产类信息,仅供参考,不构成投资建议;本网内容,包括并不限于健康、保健信息,亦非专业意见、医疗建议,请另行咨询专业意见。本网联系邮箱:contact@cacnews.ca

|